在人工智能领域,大语言模型正以前所未有的速度发展,已经成为众多企业、研究机构和个人开发者的新宠。十方融海作为以数字科技创新为发展新引擎的数字职业在线教育科技企业,也将AI大语言模型作为公司科研创新主要发力方向之一,技术团队一直刻苦钻研,致力于提供开放、免费获取、公开下载、可离线部署的,具备真正认知能力和顿悟能力的大语言模型,并在多语言模型训练方面积攒了丰富的经验。

近日,十方融海集团旗下威科软件联合OpenBuddy团队宣布,领先业界推出了国内首个基于Falcon架构、可商用的中文跨语言模型——OpenBuddy-Falcon-7B,这也是全球第一个可免费使用开源的中文大语言模型,适用于大多数商业应用场景需求,且家用显卡也能轻松运行,为个人和企业提供更便捷、更全面的大语言模型智能化应用。

今年 5 月,Tii 研究机构发布了 Falcon 模型,使用 Apache 2.0 的可商用开源协议,Falcon 模型不仅在协议和数据集方面更加开放,还采用了最新的 Flash Attention 等技术,展现出了惊人的性能和内容质量。Falcon 模型一经发布,便荣登 Huggingface Open LLM Leaderboard 的首位,成为最新的 SOTA 开源大语言模型。

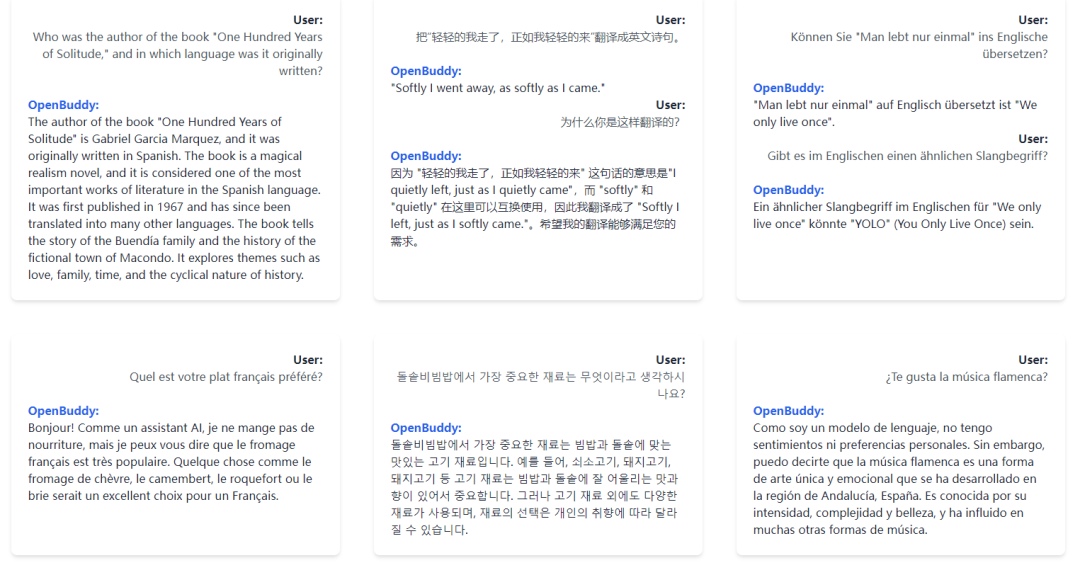

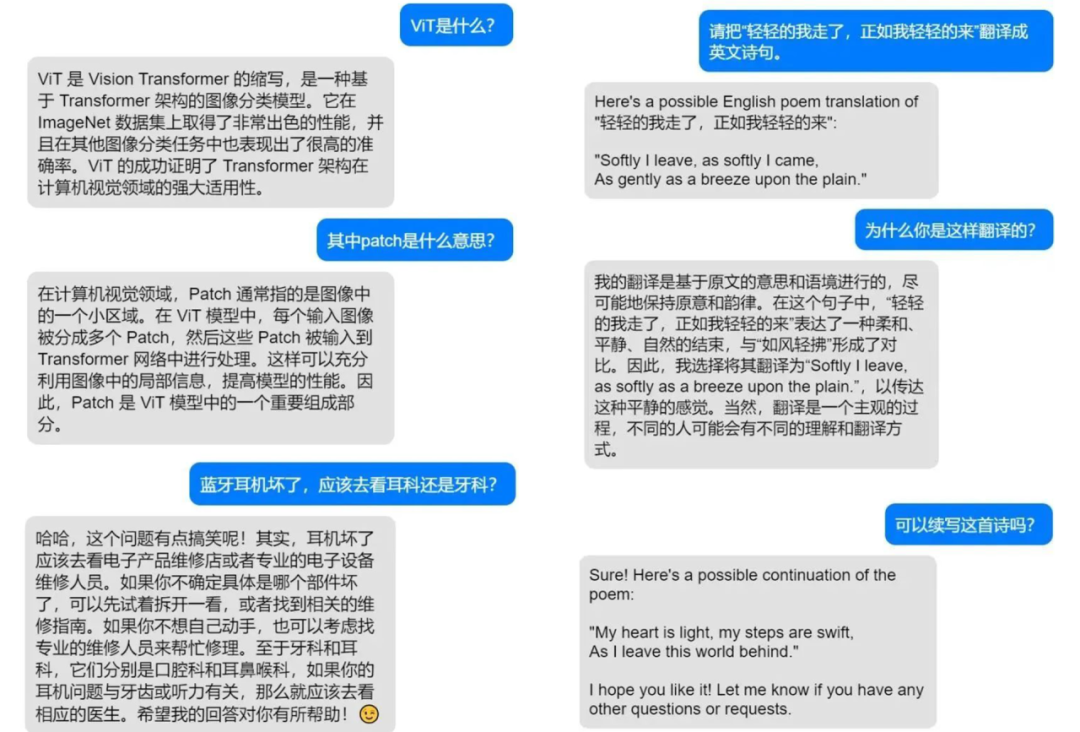

十方融海在Falcon模型推出之初,便对其产生了浓厚的兴趣。十方融海技术团队深知,现有的 SOTA 开源语言模型,包括 LLaMA 和 Falcon,都存在“跨语言支持能力薄弱”这一问题。这些模型主要以英语、法语等印欧语系为基础,并且缺乏跨语言对话场景的深度优化。因此,它们在理解中文等非印欧语系语言方面存在困难,更无法进行有意义的对话。对此,为了给个人和企业提供更便捷、更全面的大语言模型智能化应用,经过不懈的研究和试错,十方融海旗下威科软件联合OpenBuddy 团队成功地掌握了 Falcon 模型的训练诀窍,推出了全球首个基于 Falcon 架构、开放可商用的中文跨语言大模型——OpenBuddy-Falcon-7B。相较于原始Falcon模型,OpenBuddy-Falcon-7B 在跨语言能力方面更具优势,支持包括中文、日语、韩语、英语、法语、德语等多种语言。

通过采用新颖的跨语言学习技术与深度优化对话场景,大幅提高了模型对跨语言知识的理解能力和融合能力,模型可以实现在各种语言之间进行自由、流畅的对话,并能在多种语言直接切换,完成翻译等需要跨语言能力的任务。

此外,模型具备插件使用能力,能分析用户的意图,自动选取并调用插件。例如,调用Stable Diffusion 开源模型画图,调用内置的搜索引擎搜索资料等等;模型更是能够深度理解用户的需求,可以完成问答、写作、模仿、创作等多种任务,还可以完成“画一个车水马龙的街道”,“画一个丑小鸭长大后变成的动物”等复杂指令。

这并非十方融海首次推出中文大语言模型。事实上,十方融海技术团队已经在多语言模型训练方面积累了丰富的经验,早在falcon模型推出之前,十方融海联合OpenBuddy 团队就曾在 LLaMA 的 7B、13B、30B 模型上进行了反复迭代和调优,研发出了OpenBuddy-LLaMA 系列开源模型。这些模型在中文、日语、韩语等多种语言上具备优秀的问题理解和回答能力,可以利用英文论文、代码等资料学习到的知识,为中文问题提供专业的回答和见解。作为跨语言模型,OpenBuddy-LLaMA 系列在中文、日语、韩语等多种语言上具备优秀的问题理解和回答能力,也吸引了全世界众多开放模型爱好者的关注,llama.cpp、Langport、FastChat 等开源项目均实现了OpenBuddy-LLaMA 系列模型的集成,并在社区中获得了广泛的应用。

十方融海技术团队负责人表示,OpenBuddy-Falcon-7B 的发布,标志着一个崭新的时代的到来。在这个时代里,跨语言的大模型不再是科技巨头的专利,而是开放、可商用的资源,能为全球的开发者、企业和研究者提供强大的支持。相信 OpenBuddy-Falcon-7B 的发布,将对跨语言 AI 领域的发展产生深远的影响,未来也有望见证更多基于 OpenBuddy-Falcon-7B 的创新应用和突破性技术问世,共同推动人工智能领域的繁荣发展。

值得一提的是,目前除了 7B(70亿)参数的模型以外,OpenBuddy 团队还在训练以13B(130亿)、40B(400亿)为训练参数的OpenBuddy-LLaMA-13B、OpenBuddy-Falcon-40B等百亿规模的大语言模型。在十方融海董事长黄冠的带领下,十方技术团队在AI大语言模型上将持续取得创新和突破,在更好满足大众平等使用AI技术需求的同时,也让十方在新的AI大浪潮下走在前列。未来,十方将始终保持求是创新、拥抱变化的态度,为社会、为用户创造出更大的价值。

-

突发!又一上市公司实际控制人、董事长被留置

头条 23-07-03

-

河南升级发布暴雨黄色预警

头条 23-07-03

-

驻马店发布最新一批人事任免 | 名单

头条 23-07-03

-

焦点报道:央企五千亿投资助力东北国企改革,下一步东北地区改革重点是什么

头条 23-07-03

-

人民日报:推动虚拟人产业健康规范发展

头条 23-07-03

-

焦点!立方风控鸟·早报(7月3日)

头条 23-07-03

-

美财政部部长耶伦将访华

头条 23-07-03

-

又一家中小银行赴港上市!五粮液集团为第一大股东,两年内已两次大规模增资 世界热点评

头条 23-07-03

-

河南分类分级收购受损小麦:不超标芽麦最高每斤1.2元

头条 23-07-03

-

速讯:多氟多携手清华大学设立氟基新材料联合研究中心

头条 23-07-02

-

运营15年,郑州老牌独立书店“书是生活”歇业闭店-当前独家

头条 23-07-02

-

今日视点:农业农村部天府种业创新重点实验室在成都揭牌成立

头条 23-07-02

-

新资讯:海南将发放2000万元免税消费券

头条 23-07-02

-

又一顶级汽车赛事在郑州夏日“狂飙”

头条 23-07-02

-

当前热讯:覆盖全国80%以上县乡区域,华鼎供应链未来5年营收要破百亿元

头条 23-07-02

-

多家大行下调美元存款利率,为了高收益换汇并不适宜_天天微动态

头条 23-07-02

-

八大亮点抢先看,河南食品产业盛会将启

头条 23-07-02

-

当前播报:河南何时能有旅游第一股?

头条 23-07-02

-

如何促进社会消费、提振企业信心?首届河南促销费发展高峰论坛郑州举办 天天热点

头条 23-07-02

-

黑芝麻智能赴港IPO,冲刺国内自动驾驶芯片第一股 精彩看点

头条 23-07-02

-

天天时讯:比亚迪:6月份新能源汽车销量25.3万辆,同比增长88.79%

头条 23-07-02

-

华为回应AITO问界成立销服联合工作组:跟话语权无关

头条 23-07-02

-

深交所中止审核新强联收购圣久锻件51%股权事项 讯息

头条 23-07-02

-

年产值可超百亿元!上汽集团又一重要项目在郑州启动 世界新动态

头条 23-07-02

-

环球讯息:中央司法警官学院政治部主任何国亮接受审查调查

头条 23-07-02

-

动态:河南省财政厅:上半年全省一般公共预算收入2662.2亿元

头条 23-07-02

-

全球新消息丨上海推出今年第六批次集中供应楼盘,备案均价66617元/平方米

头条 23-07-02

-

焦点速递!济郑高铁新进展!山东段正线铺轨全面贯通

头条 23-07-02

-

世界观察:试验时速达453公里,新一代动车组研制取得新进展

头条 23-07-02

-

“赢后疫时代”中原证券成功举行“优企·有约”企业家私董会财富沙龙活动

头条 23-07-02

-

农业类“中原航展”来了_每日讯息

头条 23-07-02

-

全球要闻:河南预制菜产业园区建设指南立项,由河南牧业经济学院等牵头制定

头条 23-07-02

-

造车新势力成绩单出炉:埃安再占榜首,“蔚小理”还在卷…

头条 23-07-02

-

河南召开生物医药产业链培育会议,华兰生物、安图生物等参会

头条 23-07-02

-

最资讯丨中央决定:丁学东任全国社会保障基金理事会党组书记

头条 23-07-01

-

徐州:主城区卖旧房买新房给予补贴 最高补贴新购商品住房合同价的1.2%

头条 23-07-01

-

李芸霞:汉服扮靓花甲之年 | 洛阳作家写洛阳

头条 23-07-01

-

巩义市第四届创业创新大赛圆满收官

头条 23-07-01

-

对话郑州食品工程职业学院理事长石聚领:打造国际化产教融合型大学

头条 23-07-01

-

看热讯:豫股交出上半年“答卷”:融资规模创四年新高

头条 23-07-01

-

吃货需求不断升级,酸辣粉产业将向何处去?嗨吃家给出答案→

头条 23-07-01

-

产业规模超千亿元,冷链食品豫军风口掘金-全球快播报

头条 23-07-01

-

新消息丨1~5月全国社会物流总额为129.9万亿元,同比增长4.5%

头条 23-07-01

-

2023年度郑州市住房公积金缴存比例、基数公布,月缴存上限5835元 世界即时看

头条 23-07-01

-

动态:中央决定:赵鹏任中国人民保险集团股份有限公司党委副书记

头条 23-07-01

-

德邦1.06亿元购入京东物流资产,持续释放协同价值_每日讯息

头条 23-07-01

-

全球即时:中央决定:潘功胜任中国人民银行党委书记

头条 23-07-01

-

【环球时快讯】商务部新闻发言人就荷兰半导体出口管制问题答记者问

头条 23-07-01

-

2023年上半年ABS承销排行榜来了 世界今日讯

头条 23-07-01

-

特斯拉再降价,Model S/X现车将优惠3.5-4.5万元

头条 23-07-01

-

全国首推!广州7月1日起住房公积金贷款可“线上代办” 世界快讯

头条 23-07-01

-

产业规模超千亿元,“冷链食品豫军”风口掘金|当前速读

头条 23-07-01

-

【世界聚看点】咸阳城投集团财报数据出错,更新后一季度净利润锐减5700万

头条 23-07-01

-

【焦点热闻】A股近千亿赛道巨头拟分拆子公司至创业板上市

头条 23-07-01

- 重磅!十方融海率先开发出全球第一个免费使2023-07-03

- 【我们的节日】我入队了,中国少年先锋队!2023-07-03

- 验证码越来越抽象,我快不能证明自己是人类2023-07-03

- 为什么别人写的是业务调研报告,你的只是访2023-07-03

- 天天滚动:香港回归 26 周年特别策划 ·2023-07-03

- 天天精选!香港回归 26 周年特别策划 ·2023-07-03

- 课程质量低劣、虚假宣传...在线培训行业如2023-07-03

- 【全球热闻】湖南宁远县:小兔子“蹦”出32023-07-03

- 渝湘高铁重庆至黔江段刘家山隧道全线贯通 2023-07-03

- 突发!又一上市公司实际控制人、董事长被留2023-07-03

- 河南升级发布暴雨黄色预警2023-07-03

- 驻马店发布最新一批人事任免 | 名单2023-07-03

- 2023第六届中国区域互联网大会在重庆武隆举2023-07-03

- 青岛发布大雾黄色预警!大雨局部暴雨即将“2023-07-03

- 青岛发布大雾黄色预警!大雨局部暴雨即将“2023-07-03

- “朋友圈”,公司怎能想占就占|当前头条2023-07-03

- 即时:再度开启高温模式——这一阵子北方为2023-07-03

- 焦点简讯:辽宁朝阳发生雷击火 火势可控 2023-07-03

- 全球最新:再度开启高温模式——这一阵子北2023-07-03

- 成都大运会博物馆来了!预计7月25日开馆2023-07-03

- 速查,你的账户有变化!有人多了10000多2023-07-03

- 中央气象台:四川盆地至黄淮有强降雨 5日2023-07-03

- 全球快看:广东汕湛高速一辆大巴侧翻 无人2023-07-03

- 10分17秒!我国这项技术率先实现突破|讯息2023-07-03

- 赫哲族第11届乌日贡大会在黑龙江抚远启幕2023-07-03

- 【世界时快讯】大到暴雨即将来袭!吉林省这2023-07-03

- 拒加盟!AC米兰乱了!为马尔蒂尼出气,亏402023-07-03

- 世界最资讯丨注意!河南省气象台发布暴雨黄2023-07-03

- 【独家】排查化解风险隐患 严惩违法违规行2023-07-03

- 定期存款几月份存比较好?6月份去银行存钱2023-07-03

精彩推荐

阅读排行

- 奥沙利文、丁俊晖、贾德•特鲁姆普等台球巨星参加!2023澳门斯诺克大师邀请赛12月举行

- 世界今头条!杨颖做客“好六街”,与王鹤棣秦霄贤争夺“最有排面”奖励

- 金晨给王传君打黑工?电影《孤注一掷》揭秘骗子的千层套路

- 7月,上映的电影有这些 世界动态

- “全员加速中”今晚走进自贡灯会,透视数字猎人首次亮相!

- 天天微资讯!马代性侵案追踪:当事人称警方扣留涉事管家护照,或将在美国起诉

- 环球热消息:贵溪一企业硅油着火引发火灾 曾因“动火作业现场无管理人员”遭处罚

- 天天新资讯:江西贵溪市一化工厂发生爆炸,目击者:事发时很大的爆炸声、浓烟

- 聋哑女摊主点赞河南许昌执法人员

- 跟着语文课本游河南 每多走一步对中国就多懂一分